Bajo un panorama cada vez más preocupante en lo que respecta a la seguridad que compañías como OpenAI le ofrecen a los usuarios de sus herramientas, urge conocer lo máximo posible sobre lo que tienen para brindar en este apartado tecnologías como GPT-4o, el modelo de lenguaje más reciente que ha lanzado la propietaria de ChatGPT. Tomando esto bajo consideración, hace poco esta empresa ha dado a conocer los resultados arrojados por el estudio de riesgos de actividad de esta nueva incorporación.

Tanto usuarios como analistas han estado solicitándole más transparencia a OpenAI con respecto a la seguridad que proporcionan sus tecnologías, por ello, su sistema de inteligencia artificial (IA) ha sido puesto a prueba bajo situaciones simuladas durante los últimos meses, con el objetivo de percibir en qué tipo de prácticas nocivas es capaz de incidir su GPT-4o. Las conclusiones no han sido muy positivas.

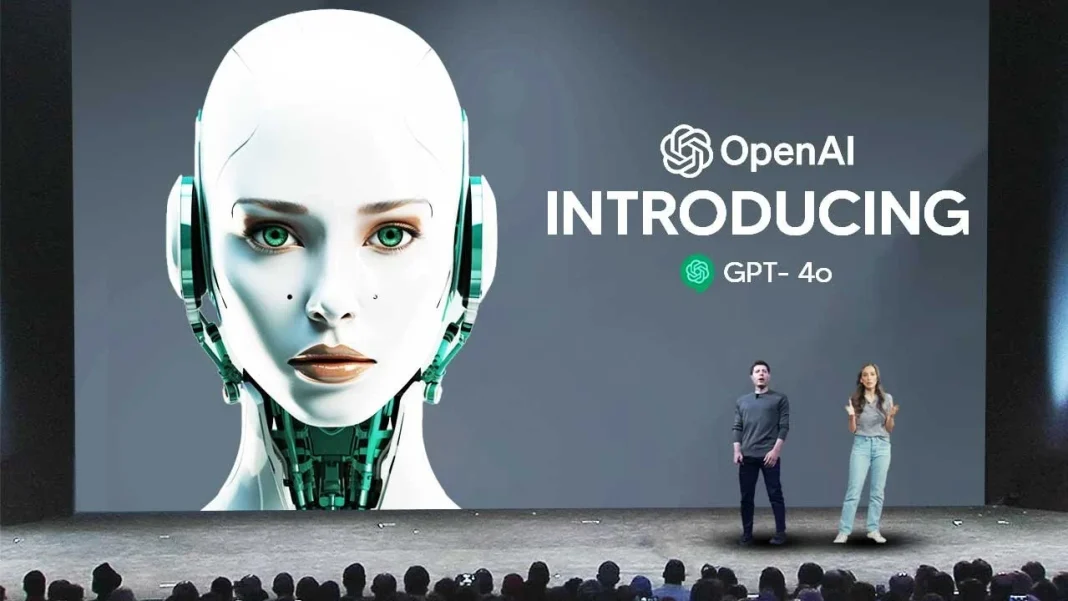

1OpenAI confirma que GPT-4o tiene un nivel de riesgo «medio»

Teniendo en cuenta que entre más avanzadas son las herramientas de inteligencia artificial, más probable es que sean empleadas para cometer actos maliciosos, el grupo externo de expertos en seguridad encargado de analizar las debilidades de GPT-4o se ha centrado en la posibilidad de crear clones de voz sin permiso, emplear contenidos con derechos de autor y generar contenido erótico o violento, a partir de la simulación de situaciones en las que la IA se enfrenta a la propagación masiva de información falsa o a un secuestro por parte de ciberdelincuentes.

Pues bien, después de tres meses del arribo de GPT-4o, OpenAI ha publicado un documento con las conclusiones del estudio, en las que los analistas confirman que este modelo de lenguaje ostenta un nivel de riesgo «medio», habiendo realizado los análisis pertinentes con base en la capacidad que tiene la IA de crear amenazas biológicas, afectar la ciberseguridad, ser autónoma y persuadir al usuario.