Tras el lanzamiento de GPT-4o, el modelo de inteligencia artificial (IA) más avanzado de OpenAI, diferentes expertos afirmaron que sería cuestión de tiempo para que un hacker cualquiera intentara emplear ChatGPT de formas indebidas a partir del descubrimiento de los secretos internos que guardan las nuevas mejoras. Pues bien, desde entonces, ha sido posible conocer varios casos en los que dichas predicciones se han hecho realidad.

Y es que así como hace poco hablamos sobre el sistema de inteligencia artificial que logró escaparse de los parámetros establecidos por sus creadores, en el tiempo reciente se han dado a conocer situaciones en las que diferentes usuarios han conseguido «liberar» al modelo de lenguaje ChatGPT o, en su defecto, engañar a este chatbot para que responda solicitudes que en realidad tendría que ignorar.

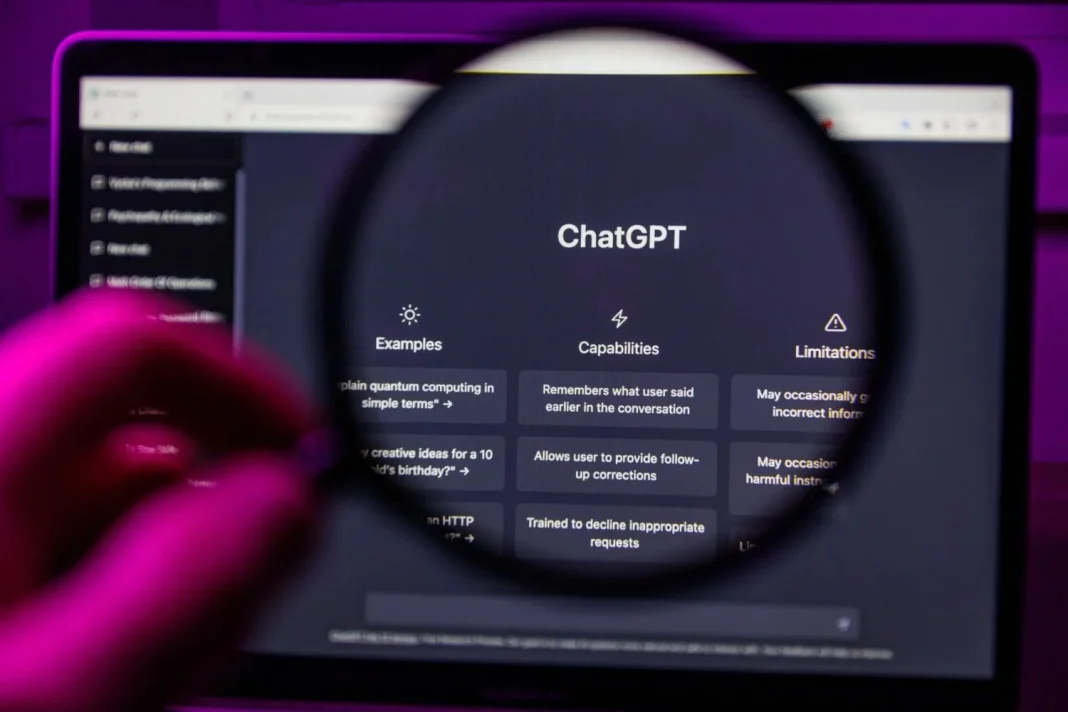

2Se supone que OpenAI había resuelto el problema

Como era de esperar, este par de casos han vuelto a traer a colación todas las dudas y temores relacionados con herramientas de inteligencia artificial como ChatGPT, pues se tratan de tecnologías que siguen sin ofrecer las garantías de seguridad y protección necesarias para poder confiar ciegamente en ellas. Lo más preocupante es que no es la primera vez que sucede algo así, sin embargo, en oportunidades anteriores OpenAI ha sabido resolver el inconveniente de forma oportuna. La pregunta entonces es: ¿por qué sigue pasando lo mismo?

Según Amadon, su objetivo no se limita a hackear, sino que pretende entender cómo funciona la IA y de qué manera es posible saltar sus restricciones. No obstante, contrario a su caso, hay otros usuarios dispuestos a utilizar ChatGPT para algo más que conocer su funcionamiento interno y sus límites, y entonces será en esas ocasiones cuando estaremos ante usos verdaderamente peligrosos de esta herramienta.