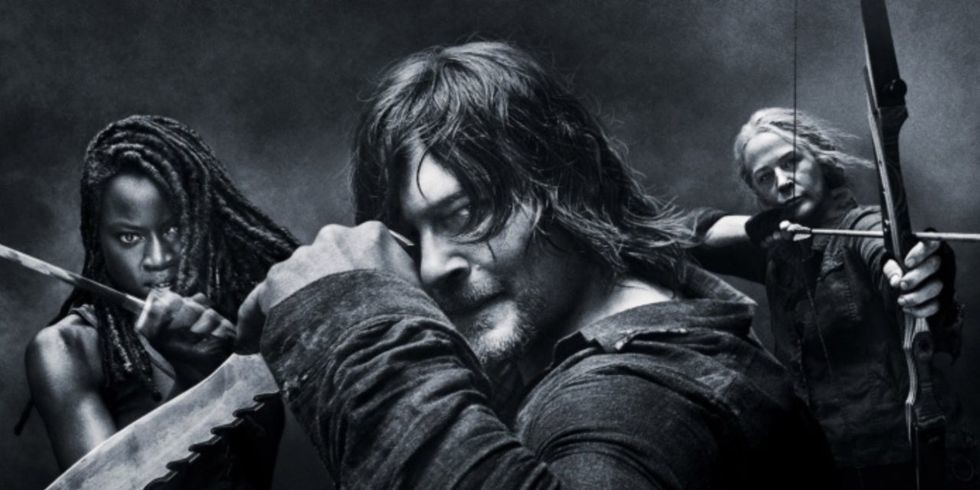

«The Walking Dead» ha sido indiscutiblemente una de las series más aclamadas en la historia de la televisión. Desde su estreno en 2010, ha cautivado a audiencias de todo el mundo con su apasionante trama post-apocalíptica, basada en el cómic homónimo de Robert Kirkman. La serie ha sido alabada por su sólida narrativa, personajes complejos y emocionantes giros argumentales que mantienen a los espectadores al borde de sus asientos. Además, ha logrado crear un universo expandido con spin-offs y películas, expandiendo aún más la franquicia. Como por ejemplo The Walking Dead: Dead City’ y ‘The Walking Dead: Daryl Dixon‘, que han sido renovadas por una segunda temporada. Te contamos más a o largo de este artículo.

2El final de la serie no significa que las historias de zombis de esta franquicia hayan terminado

Aunque «The Walking Dead» haya concluido, la franquicia de zombis aún continúa. Y todo porque hay proyectos futuros mantendrán vivo el universo apocalíptico. Los fanáticos pueden esperar más emocionantes travesías en el mundo de los muertos vivientes. Si eres uno de ellos, te recomendamos que sigas leyendo.