VidAngel es una startup que se puso en marcha en 2014 y cuya iniciativa empresarial consiste en ejercer de filtro para películas. Establecían criterios bajo los cuales eliminar escenas de desnudos, con violencia explícita o que se consideraran “blasfemas”.

El servicio que pretenden ofrecer es, evidentemente, que cualquiera pueda ver ciertas películas sin sentir que dañaban su sensibilidad.

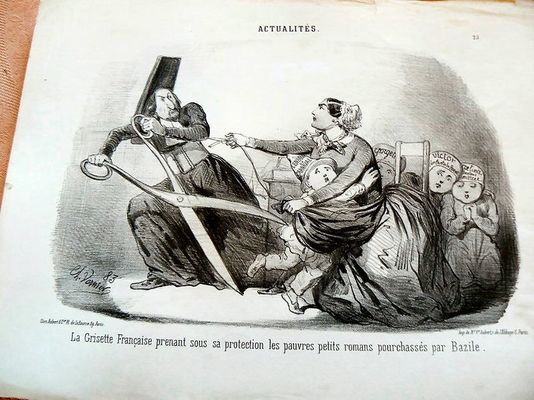

Pero los estudios cinematográficos no compartían lo supuestamente bondadoso de esta idea y no les hizo demasiada gracia que alguien se dedicara a editar los contenidos producidos por ellos sin su autorización, por lo que les demandaron.

A los estudios cinematográficos no les hizo demasiada gracia que alguien se dedicara a editar sus contenidos sin su autorización

El pasado 13 de junio se anunció que volvían, esta vez posibilitando también ver series en streaming de Netflix, HBO o Amazon de acuerdo con sus estándares.

Aunque ya hace unas semanas de esto, Wired ha publicado un artículo que analiza el núcleo central de una problemática en el mundo de la cultura que no es nueva.

Es el hecho de ofrecer a los espectadores herramientas que les permitan “protegerse” de contenidos que consideran cuando menos cuestionables.

El CEO de VidAngel, Neal Harmon, manifestó que el servicio había tenido más de tres millones de usuarios únicos solo el primer día en el que volvieron a ponerlo en funcionamiento.

Se analiza el núcleo central de una problemática en el mundo de la cultura que no es nueva

Defendió también su idea de negocio afirmando que llegaron a hacer una encuesta donde más del 40% de estadounidenses estaban de acuerdo con “filtrar” los contenidos audiovisuales.

La cuestión es saber por qué la gente desea que se editen ciertos contenidos. Según la encuesta, las personas con creencias religiosas más acusadas querían que los contenidos se filtraran porque entendían que eso era beneficioso para ellos mismos.

Las personas menos religiosas consideraron que los contenidos debían ser filtrados solo para proteger al público infantil.

Luego la gente más conservadora quería que se evitaran las escenas de contenido sexual y aquellas donde “se tomaba el nombre de Dios en vano”. Los progresistas, por el contrario, se inclinaban más por eliminar las escenas violentas y los insultos racistas.

VidAngel no es un caso aislado. ClearPlay, por ejemplo, se presenta como un servicio similar con intenciones análogas a la primera. A la misma, según Wired, se ha sumado incluso Sony.

Además no es extraño leer noticias donde se refleja que muchas redes sociales andan a vueltas con sus políticas de moderación de contenidos. El problema es que parece ser que existen bastantes más filtros que filtradores.

Las redes sociales andan a vueltas con sus políticas de moderación de contenidos

Oímos habitualmente que el filtrado de contenidos depende, al menos en buena medida, de un algoritmo.

Pero detrás de la implementación de ese algoritmo hay un montón de personas y en muchas ocasiones el mismo filtrado también se confía a todo un regimiento de trabajadores pertenecientes a la especie humana.

En un reportaje también publicado por Wired el pasado 21 de abril, se cuenta la rutina de la plantilla dedicada a este menester. Nada más introducir su contraseña para empezar la nueva jornada laboral, los empleados que Google tiene para filtrar contenido se conectan a YouTube.

Buscan contenidos violentos, expresiones que inciten al odio. Tienen que decidir si un vídeo se etiqueta como “ofensivo” o «sensible».

Y no se limitan a clasificarlos en estas dos categorías. Observando el título y el contenido tienen que decidir si lo incluyen en la etiqueta de “lenguaje inapropiado”, dentro de la cual a su vez hay otras como “obsceno”, “discurso de odio” u “otros”.

En el caso de los que van etiquetados como “violencia” se debe determinar si a su vez entran en las subcategorías de “terrorismo”, “guerra y conflicto”, “muerte y tragedia” u “otros”. Luego existen las etiquetas de “drogas” y “sexo/desnudos”.

Los filtradores dedican su jornada a ver vídeos y clasificarlos en distintas etiquetas

Wired relataba en ese reportaje de abril que estos trabajadores que tenían un contrato temporal y que eran seleccionados por agencias ajenas a la empresa en la que prestaban servicio eran los encargados de realizar un trabajo para el que los robots no están aún preparados.

Por ello un directivo de Google afirmó entonces que el gigante tecnológico se encontraba trabajando duro en el desarrollo de un filtro inteligente de contenidos, ya que consideraba que los humanos “no pueden ni deben” resolver el problema del filtrado.

No obstante, aunque este problema estuviera a las puertas de solucionarse la empresa seguiría necesitando del trabajo humano para desarrollar la inteligencia artificial necesaria para alcanzar este fin.

Un directivo de Google afirmó a ‘Wired’ que estaban trabajando para desarrollar un filtro inteligente

Wired recogió una valoración de una estudiosa de la moderación de los contenidos de carácter comercial, Sarah T. Roberts, en la cual manifestaba que advertía una indiferencia por el efecto que la criba de contenido podía tener en los moderadores.

En el caso de quienes trabajan en VidAngel y tienen este cometido pueden considerarse en principio más afortunados, ya que las películas que han de editar no tienen la carga violenta o «extremista» de los contenidos que se han de examinar en redes sociales.

Otro investigador de comunicación que estudia el procesamiento de la información y los efectos de este en la opinión pública, Albert Gunther, aseguró que la gente tiende a “sobreestimar el impacto que tienen en los otros los contenidos considerados por ellos como indeseables”.

Una investigadora se ha percatado de la indiferencia que existe hacia los efectos que puede tener en los empleados la criba los contenidos

De tal modo que cuanto mayor sea el impacto que según ellos dichos contenidos puedan tener, “favorecerán en mayor medida las restricciones” a los mismos.

Esto, finalmente, se suma a aquello que en el mundo académico se denomina “exposición selectiva” que, atendiendo a la explicación de Gunther, “es la idea de que la gente” en caso de poder elegir, “evitará de forma activa aquel contenido desagradable y con el que no está de acuerdo”.